IA: esta habilidad es clave en la era del deepfake

La detección de deepfakes y otros usos maliciosos de la inteligencia artificial se volvió crucial para proteger la confianza digital en entornos empresariales.

La expansión de los deepfakes pone en jaque la confianza digital en empresas y usuarios (Foto: SoSafe)

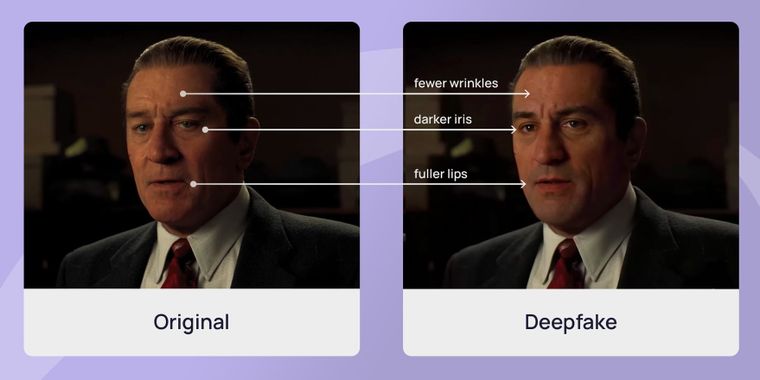

El deepfake y otros contenidos generados por inteligencia artificial son una amenaza creciente en el entorno digital. Su capacidad para imitar voces, rostros y comportamientos reales facilita fraudes, manipulación y suplantación de identidad.

Por lo tanto, detectar inteligencia artificial peligrosa, en especial en forma de deepfakes, se convirtió en un desafío urgente para las empresas. Un caso reciente expuso cómo delincuentes utilizaron videollamadas falsas con ejecutivos generados por IA para cometer un fraude de 25 millones de dólares en Hong Kong. Este tipo de incidentes demuestra cómo la tecnología puede poner en riesgo la infraestructura de confianza que sostiene las operaciones comerciales.

El crecimiento del fraude con deepfakes

El caso de la empresa Arup en enero de 2024 es un ejemplo de cómo los deepfakes ya no solo se usan en campañas de desinformación o entretenimiento, sino que ahora apuntan directamente a vulnerar sistemas empresariales. Un empleado autorizó 15 transferencias bancarias tras una videollamada con ejecutivos falsos generados con inteligencia artificial. Solo semanas después descubrieron el engaño.

Este tipo de ataques, basados en suplantación de identidad por medios digitales, crece rápidamente. Datos de la firma FS-ISAC señalan que los fraudes con deepfakes aumentaron un 1.740% en América del Norte entre 2022 y 2023. Solo en el primer trimestre de 2025, las pérdidas por estos fraudes superaron los 200 millones de dólares.

Te podría interesar

De acuerdo a la guía compartida por el World Economic Forum, las herramientas necesarias para estos ataques son cada vez más accesibles. Hoy, bastan 20 o 30 segundos de audio para clonar una voz y apenas unos minutos para generar un video verosímil usando software gratuito.

Nuevas estrategias para enfrentar el riesgo

El principal problema es que los sistemas actuales de seguridad no están preparados para esta amenaza. Las soluciones automatizadas de detección pierden precisión en contextos reales, y los humanos apenas superan el 55% de efectividad al intentar reconocer un deepfake.

Para afrontar esta situación, se desarrollan tecnologías de detección multimodal en tiempo real. Estas herramientas analizan voz, imagen y comportamiento simultáneamente, alcanzando tasas de acierto cercanas al 96% en condiciones óptimas. También se incorporan métodos de aprendizaje federado, que actualizan los sistemas con datos nuevos sin comprometer la privacidad del usuario.

Instituciones financieras están adoptando verificaciones adicionales, como autenticación biométrica basada en patrones de escritura y navegación. También se implementan demoras obligatorias para transferencias elevadas y canales alternativos de confirmación.

En paralelo, la regulación avanza. La Unión Europea ya exige que los contenidos generados por IA incluyan una marca técnica. En Estados Unidos, el Congreso debate nuevas leyes que incorporen protecciones específicas contra deepfakes en marcos más amplios de gobernanza de la inteligencia artificial.

En un entorno digital cada vez más expuesto, detectar inteligencia artificial peligrosa es vital para sostener la confianza en los procesos y canales de comunicación. La protección ante estos ataques no depende solo de la tecnología, sino también de la capacitación, los protocolos y una cultura organizacional orientada a verificar siempre.