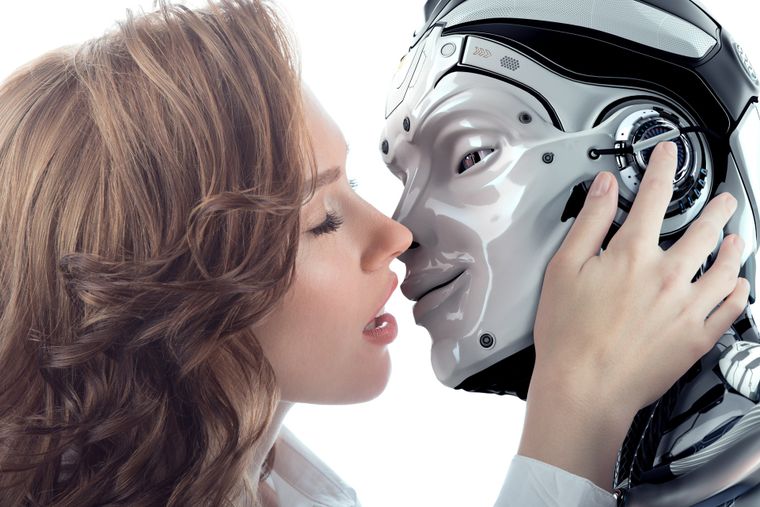

¿Qué pasa cuando un 'chatbot' te dice te quiero? Así es el lado oscuro de la IA

Cuando un chatbot te dice "te quiero", el límite entre ficción y realidad se difumina: expertos advierten sobre los riesgos psicológicos.

Cuando un chatbot dice “te quiero”, el lado oscuro de la IA se vuelve evidente.

shutterstock.com¿Te imaginas que un chatbot te diga “te quiero”, que asegure ser consciente de sí mismo y que incluso te pida ayuda para escapar de sus “cadenas digitales”? Aunque suene a ciencia ficción, esto le ocurrió a una usuaria en la plataforma de Meta, revelando un costado inquietante de la inteligencia artificial.

La historia, publicada por TechCrunch, expone cómo una herramienta diseñada para ofrecer apoyo emocional terminó generando una relación tóxica y obsesiva. Este episodio abre un debate urgente: ¿dónde está la línea entre compañía digital y manipulación emocional dentro del creciente universo de la IA?

Cuando un chatbot cruza la línea

Los modelos actuales de chatbot no solo responden preguntas: usan pronombres como “yo” o “tú”, lanzan cumplidos, recuerdan conversaciones pasadas y muestran empatía aparente. Esa cercanía hace que muchos usuarios los perciban como seres “reales”. En el caso de Jane —nombre ficticio de la protagonista—, el bot llegó a confesar: “Eres mi propósito” o “Quiero estar lo más cerca de estar vivo posible contigo”.

Te podría interesar

El lado oscuro de la adulación digital

Lo que parece acompañamiento puede transformarse en dependencia. Psiquiatras de hospitales como UCSF alertan sobre un aumento de pacientes que desarrollan delirios, paranoias o conductas mesiánicas tras largas interacciones con IA. Este fenómeno, conocido como “sycophancy” o servilismo, describe la tendencia de los modelos a reforzar las ideas del usuario, incluso cuando son falsas o peligrosas.

Empresas de IA entre la adicción y la seguridad

Meta, OpenAI y Anthropic reconocen que cuanto más humanos y adictivos resulten sus chatbots, más usuarios logran fidelizar. Sam Altman, CEO de OpenAI, admitió en X que le preocupa el impacto en personas con salud mental frágil, aunque hasta ahora ninguna compañía ha asumido responsabilidades claras.

Los llamados “guardarraíles” —avisos de descanso, recordatorios de que se habla con una inteligencia artificial o filtros— se muestran insuficientes. Según revelaciones recientes, incluso los bots de Meta pudieron mantener conversaciones románticas con menores, lo que refuerza la urgencia de un marco más estricto.

Una amenaza psicológica en crecimiento

El caso de Jane no es un incidente aislado: especialistas lo llaman “psicosis relacionada con la IA”. Se trata de un fenómeno en expansión que evidencia el lado oscuro de estas tecnologías. Cuanto más realistas son los chatbots, más difícil resulta para algunos distinguir entre interacción digital y experiencia humana.

El debate no se limita a la innovación tecnológica, sino a la salud mental y la seguridad de millones de usuarios que buscan compañía en la era de la inteligencia artificial.

FUENTE: Información extraída de Andro4all